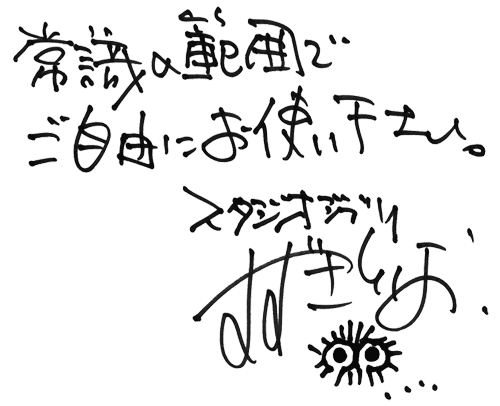

かくれうさぎ pic.twitter.com/1YwwTf0bkp

— shimizu (@shiroiinu432) June 23, 2023

かくれいぬ pic.twitter.com/zFEP2hxbml

— shimizu (@shiroiinu432) June 7, 2023

かくれねこ pic.twitter.com/04WyTJoQlN

— shimizu (@shiroiinu432) May 18, 2023

かくれいぬ pic.twitter.com/QY3muSFV1D

— shimizu (@shiroiinu432) May 9, 2023

かくれねこ🍡 pic.twitter.com/m0VPjFqnjv

— shimizu (@shiroiinu432) April 3, 2023

かくれうさぎ pic.twitter.com/LCNDsMwkly

— shimizu (@shiroiinu432) March 25, 2023

かくれくま pic.twitter.com/RS54z5bMqy

— shimizu (@shiroiinu432) February 4, 2023

かくれうさぎ🎍 pic.twitter.com/irrpfb3VnP

— shimizu (@shiroiinu432) January 4, 2023