なう

はるきー ![]()

なう

はるきー ![]()

ダンゴムシ!

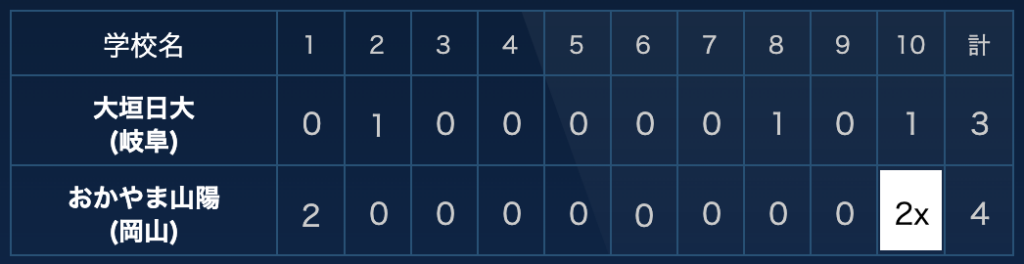

倒産しても逆転してもどっちでもいいのオレだけー!? ![]()

パク・セロイ!

2017年 韓国 ミッドナイト・ランナー

2020年 日本 未満警察 ミッドナイトランナー

リメイク!

2014年 韓国 最後まで行く🏆

2022年 フランス レストレス

2023年 日本 最後まで行く

日本版は見てないけど…

おつおつ 👏👏

Books I read recently and wanted to share. 📍

成瀬は天下を取りにいく

世界秩序が変わるとき 新自由主義からのゲームチェンジ

1%の革命 ビジネス・暮らし・民主主義をアップデートする未来戦略

22世紀の資本主義 やがてお金は絶滅する

松岡まどか、起業します AIスタートアップ戦記

なぜ、あなたの仕事は終わらないのか

私が見た未来

それなら、それで

サーキット・スイッチャー